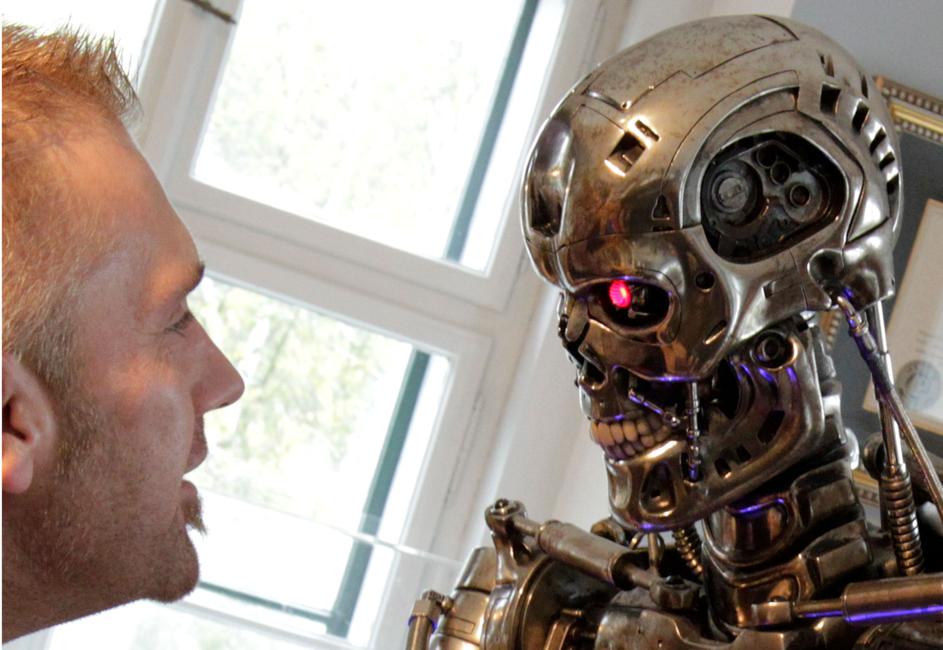

TERMINATOR

23 décembre 2016

La science-fiction, c'est maintenant et l'ONU ferait bien de s'attaquer au problème des robots tueurs avant qu'il ne soit trop tard

Malgré les quelques outils à sa disposition, l'ONU ne pourra pas empêcher complètement l'utilisation des robots tueurs sur les champs de bataille, en dépit de leur potentielle dangerosité.

0:00min

100%

100%

MOTS-CLES

robot , Terminator , guerre , armes , danger , bataille , éthique , morale , Intelligence ArtificielleTHEMATIQUES

International A PROPOS DES AUTEURS

Michel Volle est économiste français.

Diplômé de l'École Polytechnique et de l'École Nationale de la Statistique et de l'Administration Économique, il est l'auteur d'un blog dédié à l'actualité économique.

Populaires

A PROPOS DES AUTEURS

Michel Volle est économiste français.

Diplômé de l'École Polytechnique et de l'École Nationale de la Statistique et de l'Administration Économique, il est l'auteur d'un blog dédié à l'actualité économique.