©

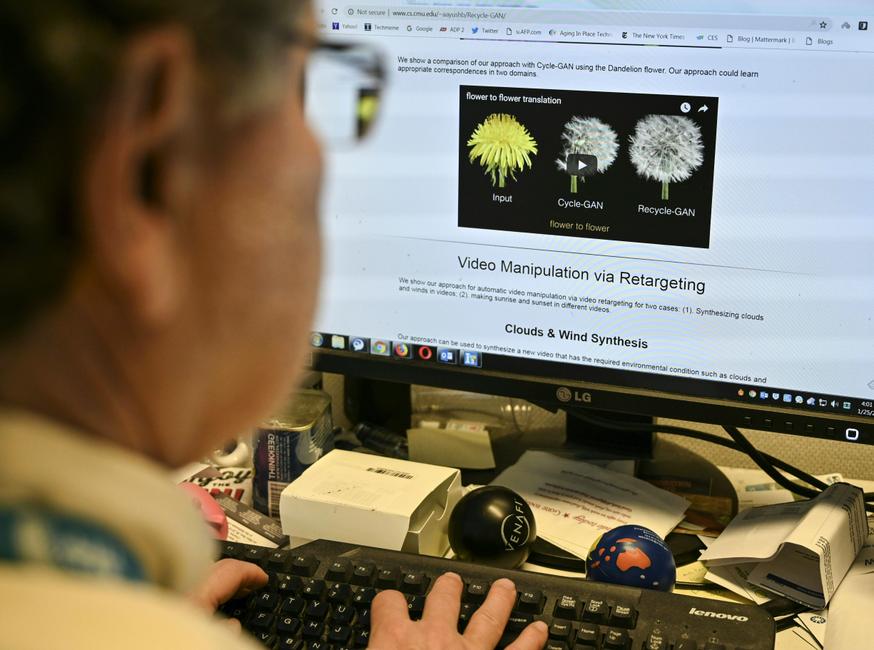

Les outils de l’IA deviennent de plus en plus performants et permettent d’apprendre puis d’imiter les voix à partir de quelques secondes de paroles, d’une discussion ou d’un discours.

MINUTE TECH

4 septembre 2023

Ces deep fakes qui imitent les voix pour mieux s’en prendre à nos comptes bancaires

L’intelligence artificielle a donné aux escrocs un outil puissant pour tenter d’inciter les gens à leur envoyer de l’argent ou pour transférer des fonds de manière irrégulière.

0:00min

100%

100%

THEMATIQUES

High-tech A PROPOS DES AUTEURS

Alexander Polonsky est Directeur de recherche, co-fondateur Bloom

Populaires

A PROPOS DES AUTEURS

Alexander Polonsky est Directeur de recherche, co-fondateur Bloom